Дубли страниц на сайте: что это, как повлиять

Дубли страниц — документы, имеющие одинаковый контент, но доступные по разным адресам. Наличие таких страниц в индексе негативно сказывается на ранжировании сайта поисковыми системами.

Какой вред они могут нанести

- Снижение общей уникальности сайта.

- Затрудненное определение релевантности и веса страниц (поисковая система не может определить, какую страницу из дубликатов необходимо показывать по запросу).

- Зачастую дубли страниц имеют одинаковые мета-теги, что также негативно сказывается на ранжировании.

Как появляются дубликаты

Технические ошибки

К ним относят доступность страниц сайта:

- по www и без www;

- со слэшем на конце и без;

- с index.php и без него;

- доступность страницы при добавлении различных GET-параметров.

Особенности CMS

- страницы пагинации сайта;

- страницы сортировки, фильтрации и поиска товаров;

- передача лишних параметров в адресе страницы.

Важно! Также дубли страниц могут появляться за счет доступности первой страницы пагинации по двум адресам: http://site.ru/catalog/name/?PAGEN_1=1 и http://site.ru/catalog/name/.

Дубликаты, созданные вручную

Один из наиболее частых примеров дублирования страниц — привязка товаров к различным категориям и их доступность по двум адресам. Например: http://site.ru/catalog/velosiped/gorniy/stern-bike/ и http://site.ru/catalog/velosiped/stern-bike/.

Также страницы могут повторяться, если структура сайта изменилась, но старые страницы остались.

Поиск дублей страниц сайта

Существует большое количество методов нахождения дубликатов страниц на сайте. Ниже описаны наиболее популярные способы:

- программа Screaming Frog;

- программа Xenu;

- Google Webmaster: «Вид в поиске» -> «Оптимизация HTML»;

- Google Webmaster: «Сканирование» -> «Оптимизация HTML».

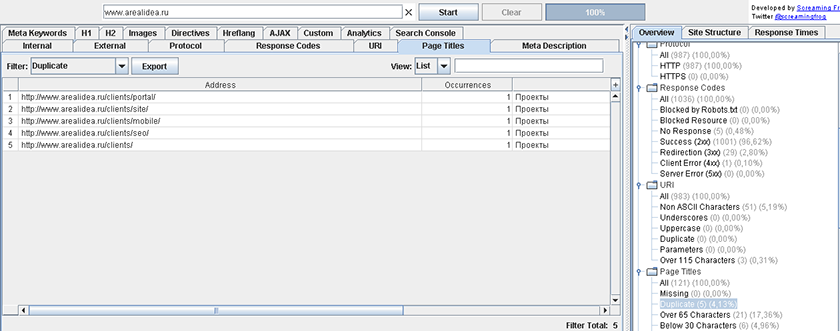

Для программы Screaming Frog и Xenu указывается адрес сайта, и после этого робот собирает информацию о нем. После того, как робот просканирует сайт, выбираем вкладку Page Title — Duplicate, и анализируем вручную список полученных страниц.

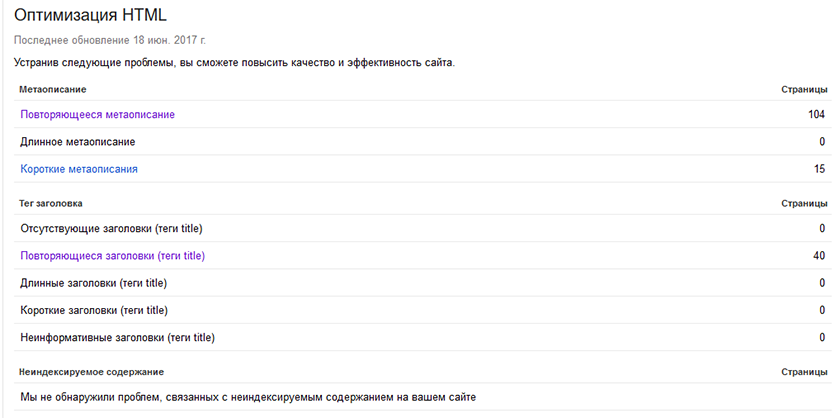

С помощью инструмента «Оптимизация HTML» можно выявить страницы с одинаковыми description и title. Для этого в панели Google Webmaster надо выбрать необходимый сайт, открыть раздел «Вид в поиске» и выбрать «Оптимизация HTML».

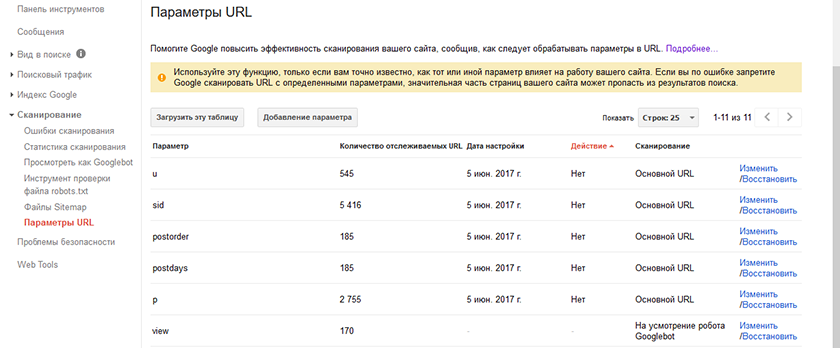

C помощью инструмента «Параметры URL» можно задать параметры, которые необходимо индексировать в адресах страниц.

Для этого надо выбрать параметр, кликнуть на ссылку «Изменить» и выбрать, какие URL, содержащие данный параметр, необходимо сканировать.

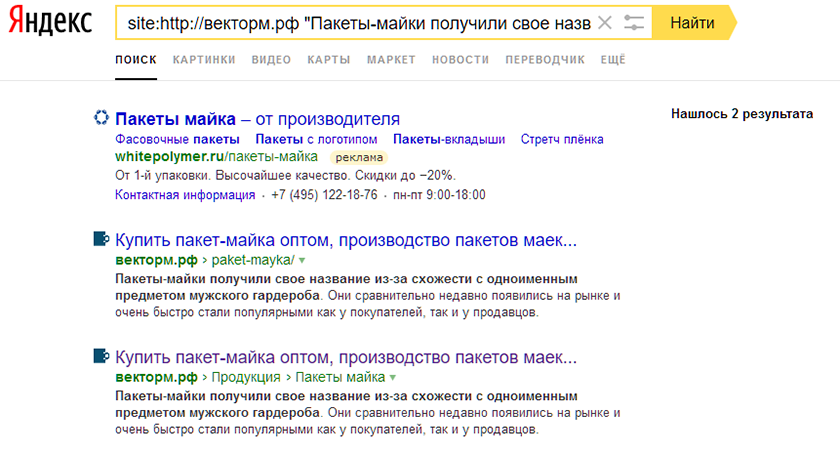

Также, найти все индексируемые дубли одной страницы можно с помощью запроса к поиску Яндекса. Для этого в поиске Яндекса необходимо ввести запрос вида site:domen.ru «фраза с анализируемой страницы», после чего проанализировать вручную все полученные результаты.

Как правильно удалить дубли

Чтобы сайт открывался лишь по одному адресу, например «http://www.site.ru/catalog/catalog-name/», а не по «http://site.ru/catalog/catalog-name/index.php», необходимо корректно настроить 301 редиректы в файле htaccess:

- со страниц без www, на www;

- со страниц без слэша на конце, на «/»;

- со страниц с index.php на страницы со слэшем.

Если вам необходимо удалить дубликаты, созданные из-за особенностей системы управления сайтом, надо правильно настроить файл robots.txt, скрыв от индексации страницы с различными GET-параметрами.

Для того чтобы удалить дублирующие страницы, созданные вручную, нужно проанализировать следующую информацию:

- их наличие в индексе;

- поисковый трафик;

- наличие внешних ссылок;

- наличие внутренних ссылок.

Если неприоритетный документ не находится в индексе, то его можно удалять с сайта.

Если же страницы находятся в поисковой базе, то необходимо оценить, сколько поискового трафика они дают, сколько внешних и внутренних ссылок на них проставлено. После этого остается выбрать наиболее полезную.

После этого необходимо настроить 301-редирект со старой страницы на актуальную и поправить внутренние ссылки на релевантные.